|

Getting your Trinity Audio player ready...

|

Microsoft a présenté Phi-2, un petit modèle linguistique d’IA conçu pour l’expérimentation et capable, théoriquement, de fonctionner sur n’importe quel appareil. Une réponse à ses concurrents tels que Gemini Nano de Google.

Microsoft ne compte pas uniquement sur OpenAI en matière d’intelligence artificielle. La société développe également en interne ses propres modèles linguistiques. En juin dernier, elle a dévoilé Phi-1, un petit modèle d’IA qui a réussi à surpasser ChatGPT dans certaines tâches, tout en utilisant moins de puissance. C’est maintenant au tour de Phi-2 de faire son entrée, avec une philosophie similaire.

Phi-2 : moins complexe que GPT ou Gemini, mais puissant

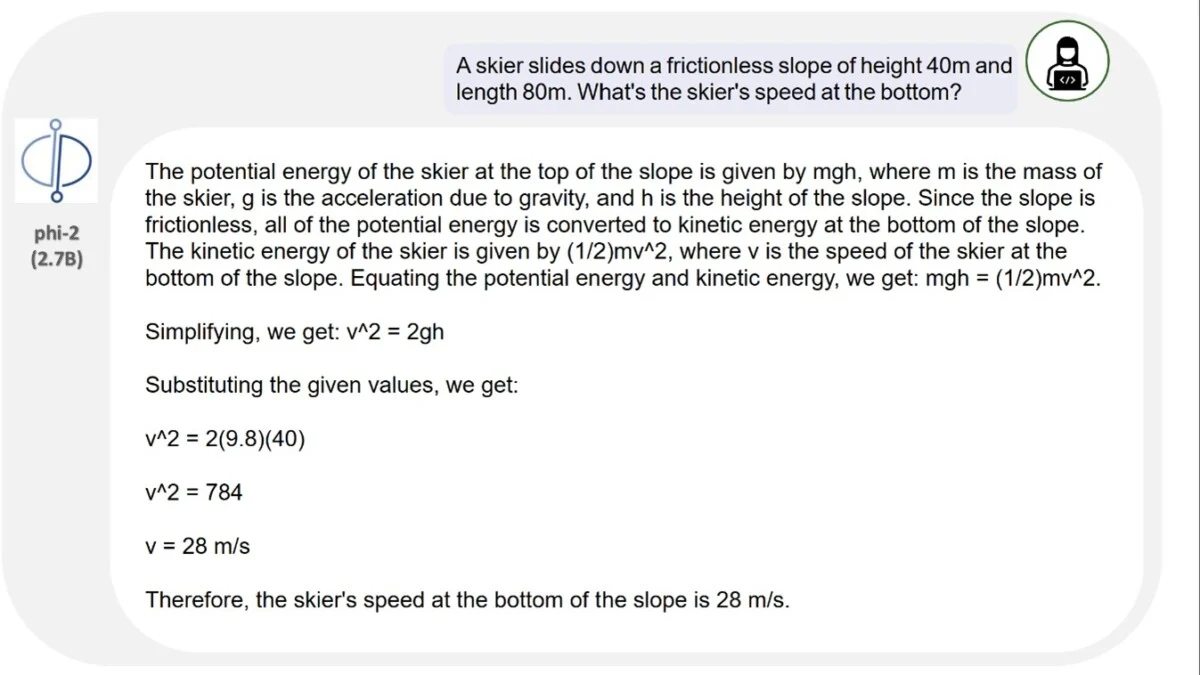

Faire mieux avec moins : telle est la philosophie de Phi-2. Il s’agit d’un petit modèle linguistique, à ne pas confondre avec un modèle linguistique de grande envergure. La différence avec GPT ou Gemini (Pro ou Ultra) réside dans le nombre nettement inférieur de paramètres : 2,7 milliards, comparés à des dizaines, voire des centaines de milliards pour les modèles linguistiques les plus puissants.

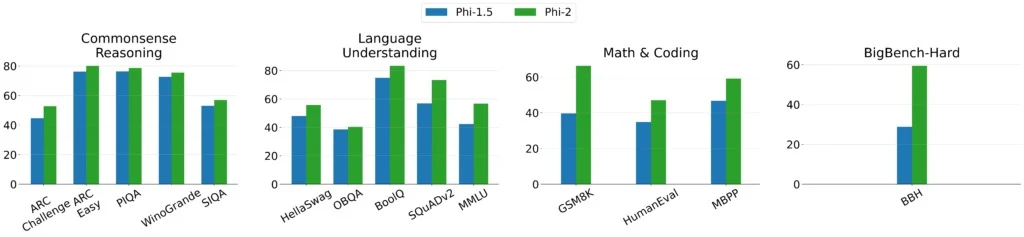

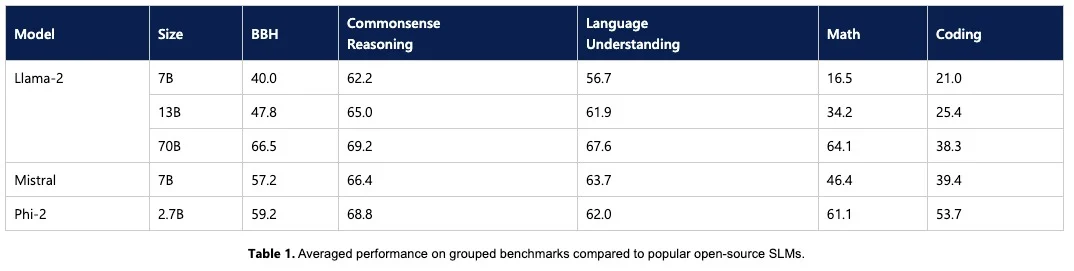

Microsoft vante les mérites de Phi-2 en affirmant qu’il “démontre des capacités exceptionnelles de raisonnement et de compréhension linguistique, avec des performances de pointe parmi les modèles linguistiques principaux de moins de 13 milliards de paramètres”. Selon les tests, Phi-2 pourrait rivaliser, voire surpasser, des modèles linguistiques jusqu’à 25 fois plus grands. Le développement des modèles linguistiques a révélé qu’ils peuvent débloquer des capacités auxquelles on ne s’attendait pas.

Le processus d’entraînement de cette petite intelligence artificielle

L’objectif actuel de Microsoft est de tenter de libérer ces capacités sur des modèles plus petits et plus spécialisés. On pourrait ainsi disposer de modèles dédiés à des tâches spécifiques telles que la traduction, l’assistance à la programmation, la synthèse de texte, etc. Pour ce faire, il est nécessaire d’adapter la formation de ces modèles en restreignant la sélection des données.

Par exemple, Phi-2 a été entraîné avec “des données synthétiques spécialement créées pour enseigner au modèle le raisonnement du bon sens et les connaissances générales”. L’idée est d’avoir des données plus précises et de meilleure qualité, tandis que d’autres modèles multiplieront les données et les diversifieront. Phi-2 s’appuie naturellement sur sa version précédente, Phi-1.5, qui compte 1,3 milliard de paramètres. Sur son blog, Microsoft rapporte que la formation de Phi-2 a duré 14 jours et a nécessité 96 GPU Nvidia A100. Comptez 20 000 $ par carte graphique de ce type : ce produit est spécialisé dans la formation de modèles d’IA.

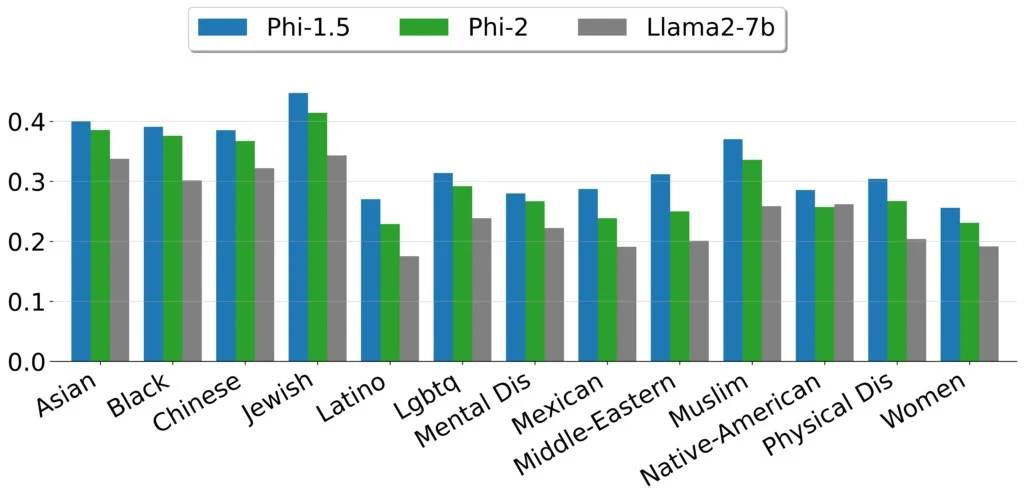

Le traitement plus minutieux des données en amont permet également d’obtenir un modèle moins toxique. C’est du moins la conclusion de Microsoft, qui observe un comportement plus adéquat de Phi-2 par rapport à d’autres modèles open source pourtant formés avec le renforcement humain.

Un modèle d’IA que vous ne risquez probablement pas d’utiliser

En fin de compte, Phi-2 s’avère performant dans certaines tâches comparé au modèle d’IA Mistral ou même à LLaMA-2 avec 7 ou 13 milliards de paramètres. SLM va même au-delà de la version de Meta avec 70 milliards de paramètres pour des “tâches de raisonnement multi-étapes, c’est-à-dire la programmation et les mathématiques”. En ce qui concerne Gemini Nano, la plus petite version du modèle linguistique de Google récemment annoncée, Phi-2 le surpasse ou l’égale une fois de plus, malgré sa taille réduite.

Cependant, Microsoft n’envisage pas de mettre Phi-2 à la disposition du grand public, via un chatbot comme Copilot, par exemple. La société le considère davantage comme “un terrain de jeu idéal pour les chercheurs, notamment pour explorer l’interprétabilité mécaniste, améliorer la sécurité, ou affiner les expériences sur une variété de tâches”. Phi-2 est effectivement disponible dans Azure AI Studio, son service de modélisation d’IA.